|

|

马上注册,结交更多好友,享用更多功能,让你轻松玩转社区。

您需要 登录 才可以下载或查看,没有账号?注册

×

作者:微信文章

大家好,我是阿娇

最近lovart国内版本星流app,火出圈了。

体验地址,网页版:https://www.xingliu.art/

也可以下载app,星流。

这次我是体验视频功能,之前用lovart主要做设计图片等,

我还写了一篇文章,关于图片设计的提示词,收到很多粉丝的喜欢,大家可以参考,拿来即用。

【实测】Lovart牛 会用的人更牛 20个案例一学就会

在星流app里,我直接在对话框中,输入:帮我生成一个从绿豆到绿豆芽的科普视频,高清写真,时长30秒。

今天以这个例子「绿豆发芽科普视频 Agent」为例,带你用一种“讲故事+类比+逐层拆解”的方式,一口气讲懂 Agent 是什么、怎么设计、怎么运作、底层代码可能长啥样、要用哪些 AI 工具和框架。没有技术背景,都能看懂,以后你就大概知道agent是如何工作的了,不会觉得它高深莫测了。

为什么这个案例特别适合解释 Agent?

因为它是一个非常清晰的「任务链 + 多模态 + 用户反馈」完整闭环,你能看到:

每一步都是 AI 真正在“干活”;

有结果图,有音乐,有视频;

Agent 每完成一步,就说一句话反馈(仿佛在汇报);

所有步骤都串得非常有逻辑。

🧠一句话解释:Agent 就像一个“AI打工人”

你可以把 Agent 理解成一个“有逻辑、有计划、会使用工具的 AI 打工人”,它不像 ChatGPT 那样只是聊天,而是能“分步骤办事”。

比如这个案例里,Agent 接到任务是:

👉 “请你做一个介绍绿豆发芽过程的科普视频”

这不是一句话能完成的事情,它需要懂得:

发芽过程要分几个阶段?

每个阶段需要生成什么图片?

怎么拼成视频?要不要加背景音乐?

背景音乐从哪来?要不要科普风格?

每一步做完要告诉用户!

这时候,一个合格的 Agent,就会像个认真负责的员工一样,动脑、动手、调用工具,一步步完成这个任务。

🧱Agent 的“骨架”:逻辑结构

你可以把 Agent 的工作流程理解成一条 “任务链”,它会把一个复杂任务拆成一个个小任务,然后依次完成。

在绿豆发芽案例里,任务链长这样:

[接收需求]

↓

[计划步骤:共需要6张图+1段音频+拼视频]

↓

[第1张图 → 生成绿豆干燥状态照片]

↓

[第2张图 → 浸泡0h、1h、2h照片]

↓

[第3张图 → 发芽阶段图]

↓

[第4张图 → 成熟期+标注结构图]

↓

[生成配套背景音乐]

↓

[用图片+音乐合成视频]

↓

[生成结果呈现给用户]

关键点:每一步 Agent 都知道干什么,用什么工具,如何衔接下一步。

🧰 Agent 的“工具箱”:能干活全靠这些插件

Agent 自己不会画图、做音乐、剪视频,它其实就是个“调度员”,它调用各种 AI 能力来完成工作。

| 任务 | 使用的 AI 技术(可能) | | 图像生成 | Stable Diffusion / Midjourney(图生图) | | 背景音乐生成 | Suno.ai / Boomy(文生音乐) | | 视频拼接 | RunwayML / Pika Labs / FFmpeg 脚本 | | 内容理解 | GPT-4o / Claude 来分析需求和组织内容 | | 结构标注 | 自定义 Prompt + GPT 生成图像说明文本 |

这些工具在 Agent 背后就像各种“小外包”,Agent 会说:“嘿,图像生成模型,帮我画个绿豆刚泡水1小时的样子!”

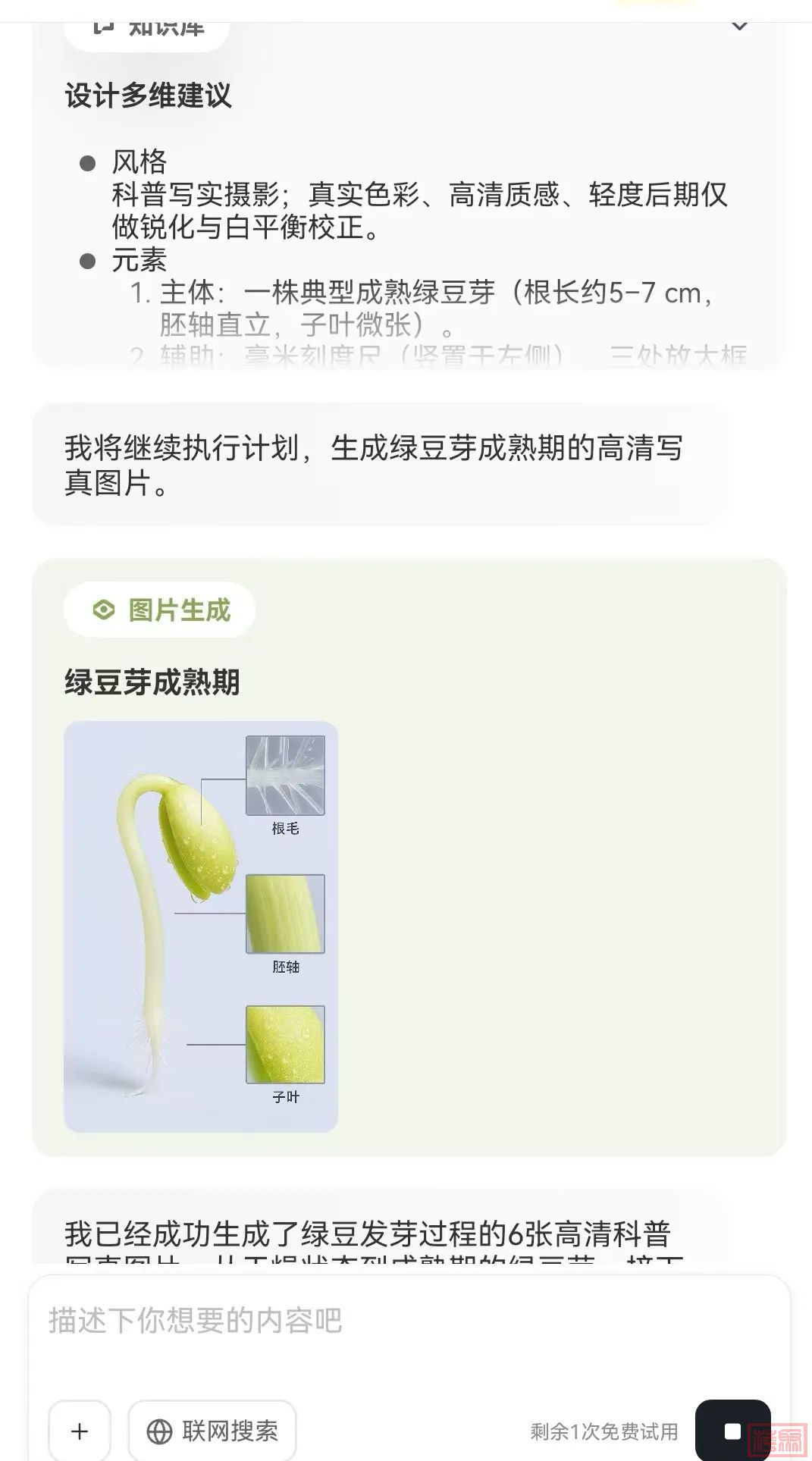

1)第一步:生成图片,调用图像生成工具插件

过程中,还展示调用了知识库,展示了详细的图片提示词

2)第二步:生成【浸泡期】图片,调用图像生成工具插件

3)第三步:生成【萌芽期】图片,调用图像生成工具插件

4)第4步:生成【初期的】图片,调用

4)第4步:生成【成熟期的图片】,调用图像生成工具插件

5)第5步:生成【背景音频】,调用文生音频插件sono.ai

6) 第5步:生成【视频】,调用可灵2.1插件工具

Agent 的“大脑”:怎么安排每一步

Agent 背后的“大脑”其实就是一个“任务计划器”,它需要有几个能力:

✅ 理解需求(用大模型解析)

“我要生成一个科普视频” → 用 GPT-4 拆解成图+文+音+视频任务

✅ 调度任务(用代码执行)

先做图,再拼视频,不能乱顺序

每一步要用哪种工具?需要什么参数?

✅ 记住中间结果(上下文记忆)

图1做完存起来,等视频合成用

风格设定参数要贯穿始终

开发一个 Agent,要准备哪些模块?

| 模块 | 作用 | 技术推荐 | | 意图理解 | 拆解用户需求 | GPT-4 / Claude / | | 任务编排 | 安排步骤,顺序,依赖 | LangChain / LangGraph / CrewAI | | 工具集成 | 封装图像、音频、视频等 API | Python + requests / SDK | | 状态管理 | 存储中间结果,保持上下文 | 内存系统 / Redis 缓存 | | 交互前端 | 呈现结果,接受输入 | React Native / Flutter / Webview |

接下来围绕这 5 个核心模块,从原理 + 作用 + 开发建议 + 技术细节的角度,做一次完整展开。即使你是刚入门 AI 应用开发,也能一步步上手。

🧠 1. 意图理解(Intent Parsing)

🧩 作用

让 Agent 能“听懂人话”,把一句话需求拆成多个具体小任务。

比如用户说:

“请生成一个绿豆发芽过程的科普视频”

Agent 要理解:

“科普视频” = 需要图像 + 音频 + 文字 + 视频合成

“绿豆发芽过程” = 至少包括干燥 → 浸泡 → 发芽 → 成熟几个阶段

输出形式 = 视频 + 中间素材

🔧 技术建议

使用 GPT-4 / Claude 生成任务清单

可以引导生成 JSON 结构的 task plan,便于后续解析执行

✅ 示例 Prompt

请你作为一个智能助手,把这句话拆解成多个步骤,每步说明要做什么、使用什么工具:

“我要做一个绿豆发芽过程的科普视频。”

输出 JSON,每一步包含:

- name: 步骤名

- description: 做什么

- tool: 可能使用的工具名🔗 2. 任务编排(Task Planning / Orchestration)

🧩 作用

把意图理解出来的任务顺序执行、判断依赖关系、错误处理、并发控制。

比如你不能先合成视频再做图,要先做完所有图像和音乐,最后再视频合成。

🔧 技术推荐

| 工具 | 说明 | | LangChain | 支持 Agent 执行链、工具注册、对话状态控制 | | LangGraph | 更高级的“任务图”系统,适合任务有分支、循环、条件判断的场景 | | CrewAI | 多 Agent 协作框架,每个 Agent 有职责,如图像专家、文案专家 |

✅ 实现建议

定义 Task 类,每个类有:执行函数、前置条件、依赖输出、错误处理

维护一个 Task DAG(有向图)或顺序队列,根据依赖自动排序执行

🛠️ 3. 工具集成(Tool Calling / Plugin Binding)

🧩 作用

Agent 本身不会“画图/剪视频/生成音乐”,它需要调用这些功能的外部 API 或模型,就像打工人用工具。

🧰 工具类型与调用方式

| 工具类型 | 示例 | 调用方式 | | 图像生成 | DALL·E, SDXL, Midjourney | API or SDK | | 音乐生成 | Suno, Boomy, MusicGen | API | | 视频合成 | RunwayML, Pika Labs, FFmpeg | API or Shell 脚本 | | 文本生成 | GPT, Claude | SDK or OpenAI API |

🧠 4. 状态管理(Memory & Context Storage)

🧩 作用

Agent 不是一次性问答,它需要记住之前的输出、当前在哪一步、有哪些图像文件已经生成等。

🧰 技术方案

| 类型 | 技术 | 用途 | | 本地内存 | Python 字典 | demo 快速跑通 | | 持久化缓存 | Redis | 存储中间变量、图片路径、任务状态 | | 数据库 | SQLite / MongoDB | 多用户多会话任务存储(进阶) |

✅ 示例

self.memory = {

"image_1": "url1.png",

"image_2": "url2.png",

"music": "music.mp3",

"video_status": "pending"

}

结合 Redis 存储:

redis.set(f"user:{user_id}:step:1", "done")📱 5. 交互前端(User Interface)

🧩 作用

让用户清晰看到每一步执行结果、还能输入下一步需求。

✨ 好的前端需要:

展示每步结果(图像、音乐、视频、任务描述)

可以追踪当前任务进度(进度条或提示语)

可以编辑某一步参数(比如风格、音乐风格等)

提供下载/播放/分享等功能

🔧 技术推荐

| 技术 | 场景 | | Flutter | 跨平台 App,适合手机端(如星流 app) | | React / Next.js | Web 端 Agent 控制台 | | WebView + 原生模块 | 嵌入式 Agent UI + 原生音视频播放控件 |

🧩 总结一句话:

Agent 就是你请来的一位“有大脑 + 有工具 + 懂流程 + 会反馈”的 AI 员工,帮你自动完成复杂任务,比如做视频、写文案、查资料、生成作品等。

【关于我】

|

|